Hoje em dia, o ciclo de notícias da AI é dominado por Deepseek. O Deepseek é uma startup chinesa que lançou um modelo de raciocínio tão poderoso quanto o Chatgpt O1, apesar de não ter os enormes recursos de hardware e infraestrutura do OpenAI. O Deepseek usou chips e otimizações de software mais antigos para treinar Deepseek R1.

As acusações do OpenAI de que o DeepSeek podem ter destilado o Chatgpt para treinar precursores de R1 nem importa.

O projeto Deepseek provavelmente alcançou seu objetivo em várias frentes. Ele nivelou o campo de jogo nas guerras da IA, dando à China uma chance de lutar. A Deepseek também deu um enorme golpe financeiro ao mercado de ações dos EUA, que perdeu quase US $ 1 bilhão, com as empresas de ferragens da IA representando as maiores perdas com valor de mercado.

Finalmente, Deepseek deu à China uma arma de software que pode ser ainda mais poderosa que Tiktok. Deepseek é o aplicativo número um na App Store. Além disso, qualquer pessoa pode instalar o modelo Deepseek em seu computador e usá -lo para criar outros modelos.

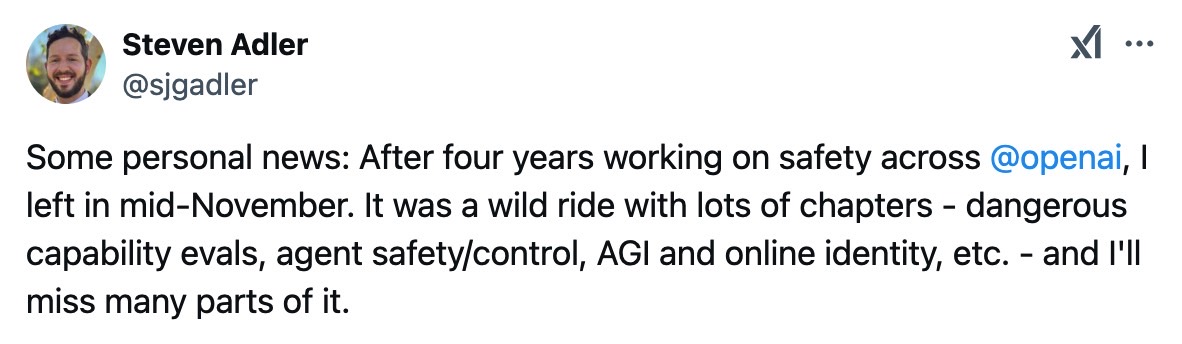

Com tudo isso em mente, você pode nem prestar atenção aos relatórios dizendo que outro pesquisador de segurança do OpenAI de chaves desistiu. Steven Adler é outro nome que adicionaremos a uma lista crescente de engenheiros que deixaram o Openai no ano passado.

Também é interessante que o engenheiro tenha saído em meados de novembro, mas tornou seu público o público na segunda-feira, assim como o DeepSeek News caiu no mercado.

Adler disse em X que está deixando a empresa depois de quatro anos. “Foi um passeio selvagem com muitos capítulos – evalas de capacidade perigosa, segurança/controle de agentes, AGI e identidade on -line etc. – e sentirei falta de muitas partes”, disse ele antes de lançar um comunicado sombrio.

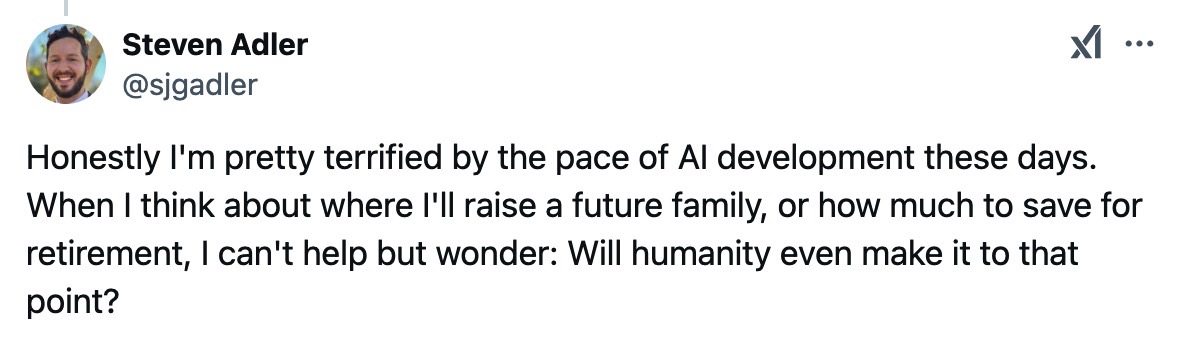

O pesquisador disse que está “muito aterrorizado com o ritmo do desenvolvimento da IA hoje em dia”. A observação de Adler ecoa os medos de outros especialistas da IA que pensam que a IA trará nossa inevitável destruição. O ex -pesquisador de segurança do ChatGPT não mediu palavras, dizendo que está preocupado com o futuro.

“Quando penso em onde vou criar uma família futura ou quanto economizar para a aposentadoria, não posso deixar de me perguntar: a humanidade chegará a esse ponto?” ele perguntou.

Eu ficaria curioso para saber o que Adler viu no Openai que o fez deixar a empresa. Eu ficaria ainda mais curioso ao saber por que ele não ficou por aqui para ajudar a salvar a humanidade da IA ruim, envolvida em uma das empresas de IA mais importantes por aí.

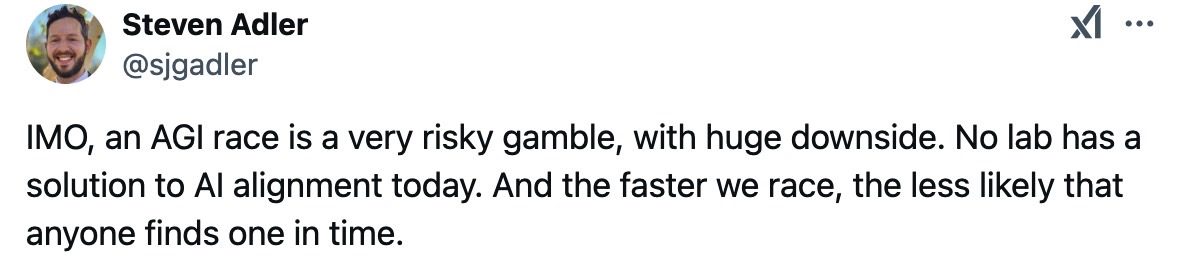

Adler pode ter testemunhado a pesquisa da AGI (Inteligência Geral Artificial) no Openai, algo que a empresa está se desenvolvendo claramente. Estou especulando aqui, mas é baseado em um tweet de acompanhamento. Adler disse: “A AGI Race é uma aposta muito arriscada, com enorme desvantagem. Nenhum laboratório tem uma solução para o alinhamento da IA hoje. E quanto mais rápido corremos, menor a probabilidade de alguém encontrar um a tempo. ”

Presumivelmente, o Openai está acelerando nessa raça AGI. AGI é o tipo de IA que corresponderá à criatividade e capacidade de um humano quando encarregado de tentar resolver qualquer problema. Mas a AGI também terá muito mais informações, para que possa abordar qualquer tarefa muito melhor que um humano. Pelo menos essa é a ideia.

O alinhamento é a questão de segurança mais importante relativa à IA, AGI e Superintelligence (ASI). A IA deve estar alinhada com os interesses da humanidade em todos os níveis. Essa é a única maneira de garantir que a IA não desenvolva agendas próprias que possam levar à nossa morte.

No entanto, produtos da vida real como ChatGPT e Deepseek já nos dão dois tipos de alinhamentos. Chatgpt está, esperançosamente, alinhado conosco e interesses ocidentais. O Deepseek é construído com interesses chineses primeiro e está alinhado com eles via censura.

Adler também parecia se referir a Deepseek em seu tópico de segunda -feira em X sem nomear a startup chinesa.

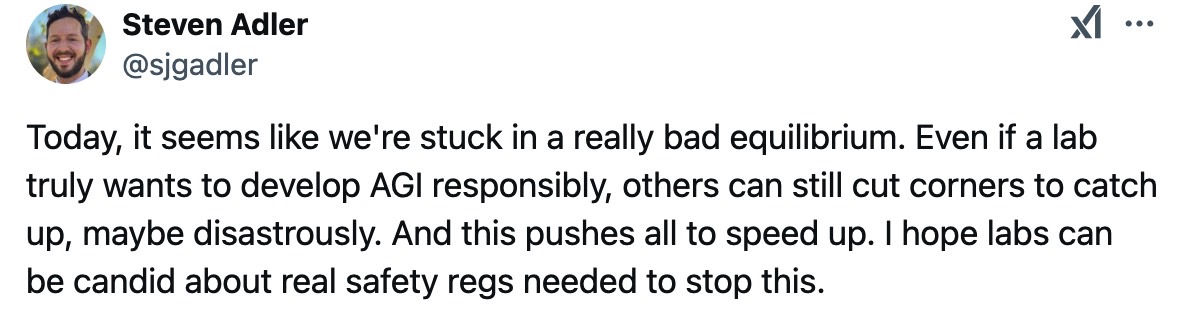

“Hoje, parece que estamos presos em um equilíbrio muito ruim”, disse ele. “Mesmo que um laboratório realmente queira desenvolver a AGI com responsabilidade, outros ainda podem cortar cantos para recuperar o atraso, talvez desastrosamente. E isso empurra tudo a acelerar. Espero que os laboratórios possam ser sinceros sobre a segurança de segurança necessária para impedir isso. ”

Como isso está ligado à IA? Bem, o modelo de código aberto Deepseek R1 está disponível para qualquer pessoa. Atores nefastos com alguns recursos, know-how e novas idéias podem tropeçar na AGI sem saber o que estão fazendo ou mesmo percebendo que desencadearam uma forma superior de IA no mundo.

Isso soa como um cenário de filme de ficção científica, com certeza. Mas isso pode acontecer. É tão válido quanto um cenário como, digamos, uma grande empresa de IA desenvolvendo AGI e ignorando os avisos dos pesquisadores de segurança, que acabam deixando a empresa uma a uma.

Não está claro para onde Adler se moverá em seguida, mas ele parece ainda estar interessado na segurança da IA. Ele perguntou a X o que as pessoas pensam que as “idéias mais importantes e negligenciadas na segurança/política da IA” estão, acrescentando que ele está empolgado com “métodos de controle, detecção de planejamento e casos de segurança”.

(Tagstotranslate) Chatgpt