Resumo

-

Deepseek é de código aberto e tem desempenho, bem como os principais modelos de IA, treinados para muito menos

-

Desenvolvido pelos engenheiros chineses, ele pode comprimir modelos complexos e funcionar localmente no hardware inferior.

-

Existem preocupações sobre suas origens e possíveis vieses.

A Internet está cheia com o nome “Deepseek”. Empresas de IA como OpenAI e Nvidia estão vendo seus preços das ações cair, e os entusiastas da IA estão esfregando as mãos com alegria em todo o mundo. Por que esse novo participante é o mundo da IA tão importante?

Deepseek é uma IA de código aberto com grandes reivindicações

Como GPT-O1 ou Claude, ou Llama, ou qualquer um dos queridos atuais da AI, o DeepSeek é um modelo de IA generativo. Bem, é mais preciso dizer que é um grupo de modelos de IA que são variantes projetadas para diferentes aplicações.

Ao contrário, por exemplo, os modelos GPT da OpenAI, o Deepseek é de código aberto sob a licença do MIT, que permite o uso comercial. Isso significa que todo o funcionamento interno do modelo está aberto para ver. Qualquer pessoa pode usá -lo sem pagar taxas de licenciamento de qualquer tipo, e não há nada que impeça alguém de modificar ou construir o trabalho que já foi feito. Essa é uma das principais razões pelas quais a Deepseek levou a uma interrupção do mercado de curto prazo, que pode se transformar em uma correção de mercado de longo prazo.

No entanto, nada disso realmente importa se o Deepseek não for bom. O outro fator importante que todos falam sobre esse modelo de IA é o desempenho do desempenho. Nos benchmarks de IA, o DeepSeek realiza, bem como o GPT-O1 e outros modelos generativos de estreia. Melhor ainda em alguns casos. Obviamente, isso é algo que alguém pode verificar, mas a afirmação verdadeiramente chocante é quanto custa desenvolver esse modelo.

Deepseek afirma que o modelo foi treinado por menos de seis milhões de dólares. O que parece muito dinheiro até você considerar que os modelos que estão negociando com custos superiores a cem milhões de dólares para treinar. Não apenas isso, mas o Deepseek foi treinado em hardware menos poderoso do que o que está disponível para empresas como o OpenAI. Obviamente, essa é uma das alegações que não é tão facilmente verificada, e é possível que o valor citado seja muito menor que a verdade. No entanto, por enquanto, não há arma para fumar para indicar que os custos foram mais altos do que os reivindicados.

O último “grande negócio” que vale a pena mencionar sobre a Deepseek é como ele foi usado para “destilar” modelos grandes, densos e computacionalmente caros, como a LLama em modelos menores com habilidades de raciocínio comparáveis. Basicamente, a DeepSeek treina um modelo de modelos maiores mais complexos para imitar suas saídas, sem todas as maquinações complexas sob o capô. Ele está efetivamente comprimindo modelos maiores em outros menores com (até agora) poucas desvantagens aparentes. Este é um grande salto para executar modelos complexos localmente, usando menos energia e precisando de menos hardware.

Deepseek foi desenvolvido por engenheiros chineses

Deepseek é uma startup liderada por Liang Wenfeng (39), que viu o sucesso como gerente de fundos de hedge. Especificamente, um gerente quantitativo de fundos de hedge. Essa é uma abordagem do investimento que usa o aprendizado de máquina para prever tendências de mercado, para que os investidores possam lucrar com ele. É por isso que Wenfeng já tinha acesso ao poderoso hardware necessário para treinar esse modelo.

Deepseek parece ser o que equivale a um projeto de paixão e não está procurando torná-lo um empreendimento com fins lucrativos. De fato, o modelo já foi doado a todos, sendo de código aberto. Ironicamente, os EUA embarcam em poderosos chips de IA de empresas como a Nvidia, podem ter sido parte do motivo pelo qual os desenvolvedores da Deepseek foram forçados a torná -lo tão eficiente.

Você pode tentar Deepseek agora

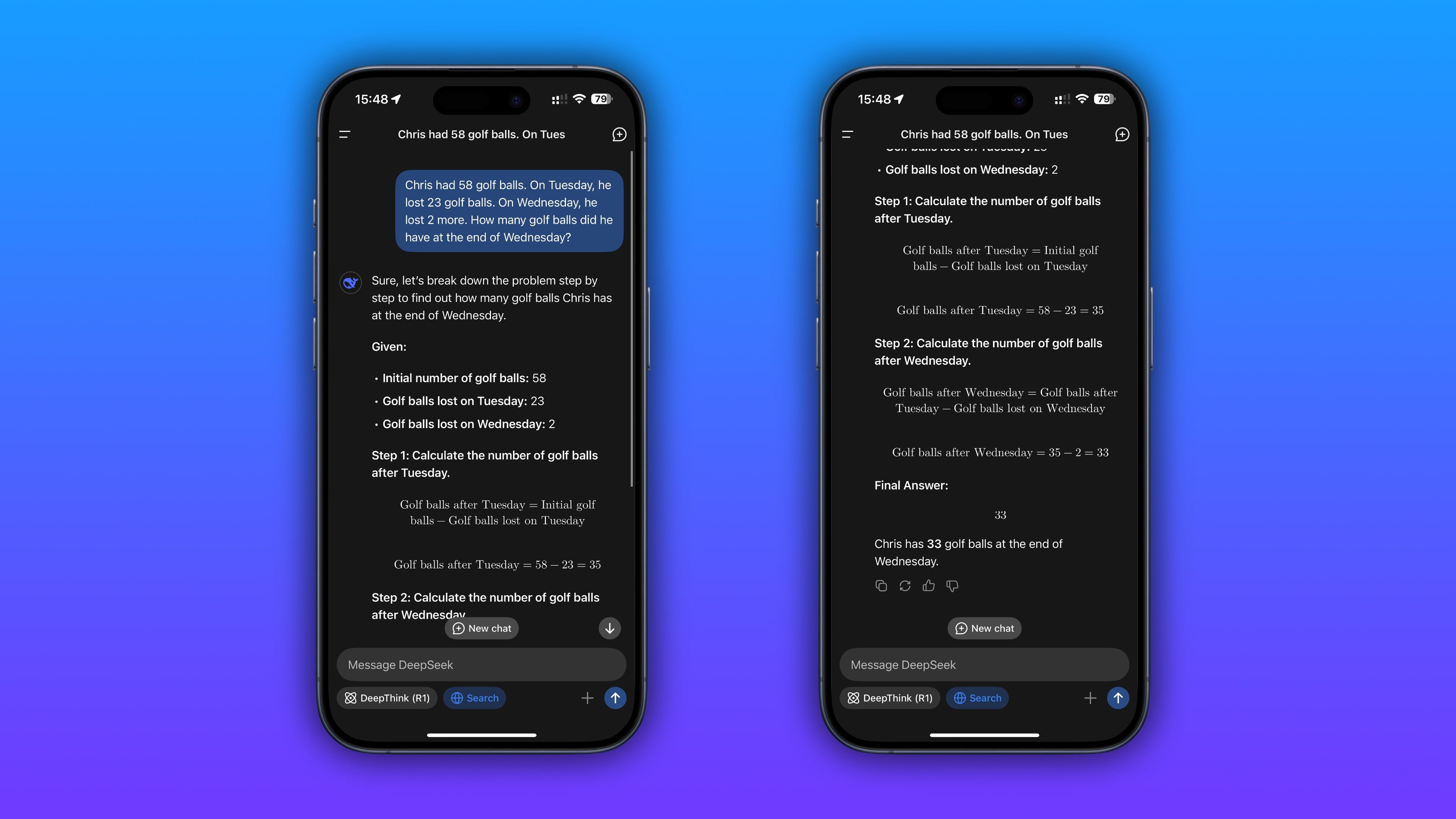

Se você visitar o site Deepseek, poderá ter acesso ao aplicativo e links para os modelos reais para baixar e usar em seu próprio hardware. A maneira mais fácil de executar alguma versão do DeepSeek em seu próprio hardware é usando o Ollama.

Obviamente, você não vai executar o modelo Deepseek de nível GPT-O1 em seu laptop tão cedo, mas por alguns milhares de dólares em GPUs e RAM de ponta, é totalmente possível. Obviamente, existem muitos modelos menores de Deepseek que não são tão bons, mas funcionam bem no computador que você provavelmente tem agora. Caramba, existe até uma versão que será executada (apenas) em um Raspberry Pi.

Existem algumas preocupações especiais com o DeepSeek

Considerando como partes da história Deepseek podem parecer boas demais para ser fiel a alguns especialistas na indústria da IA e que se origina na China, o que levanta preocupações sobre preconceitos, censura e até segurança cibernética, não é surpresa que haja alguma hesitação sobre a defesa profunda.

De fato, pergunte à versão hospedada on -line das perguntas LLM que são sensíveis ao atual governo chinês, e pode não ser o mais próximo possível. No entanto, como o código está aberto a todos, qualquer um pode ajustar como ele se comporta se tiver o conhecimento. Essas preocupações podem ser abordadas em princípio.

É o início dos dias para o Deepseek, e levará algum tempo para ver como as coisas vão se safar, mas uma coisa que eu não tenho dúvidas é que a indústria generativa de IA acabou de passar por sua primeira grande mudança de paradigma desde que o ChatGPT foi lançado ao público.