Autoridade Robert Triggs / Android

O Deepseek é o mais recente modelo de idioma grande a invadir a cena e agitar as coisas, tanto que é eliminado bilhões do patrimônio líquido das maiores empresas de tecnologia do mundo. O que realmente chamou a atenção de todos é como o Deepseek R1 mostra seu raciocínio, ou o que conta para o raciocínio em um LLM. Naturalmente, eu queria testá-lo e ver se poderia ser um substituto em tempo integral para o assistente no meu PC Copilot Plus.

Agora, o assistente da Microsoft se tornou um pouco mais inteligente desde que substituí o Copilot pelo Chatgpt há algum tempo, mas com o Deepseek fazendo ondas, quero ter acesso mais rápido à ferramenta mais quente da cidade. Sem mencionar, a natureza um pouco mais aberta do Deepseek me permite hospedar um grande modelo de idioma localmente também, realmente enfatizando os recursos de IA desses novos PCs. É hora de remapear essa chave copilota mais uma vez. Obviamente, se você quiser experimentar o Deepseek no seu telefone Android, também há um aplicativo para isso.

O método rápido

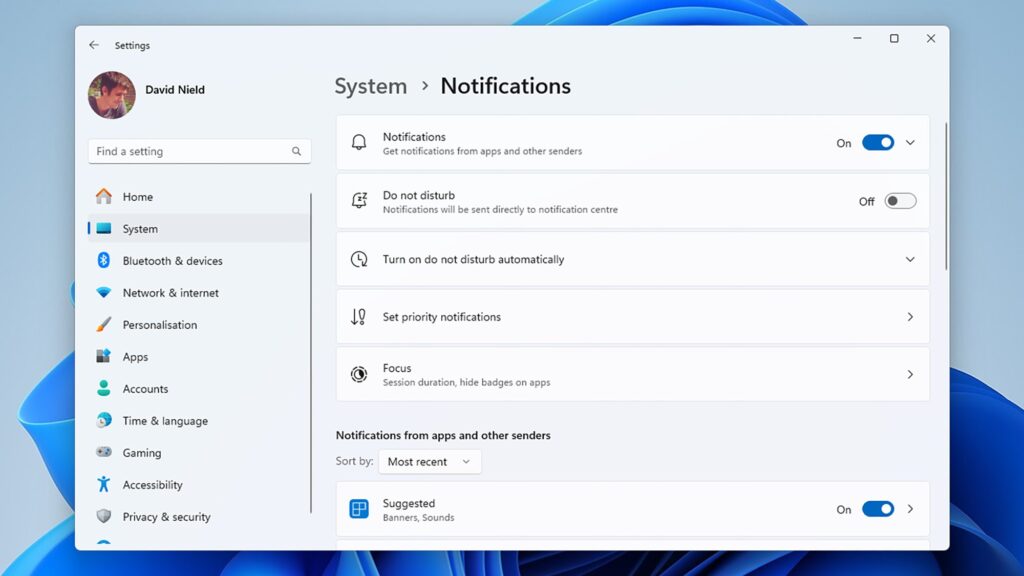

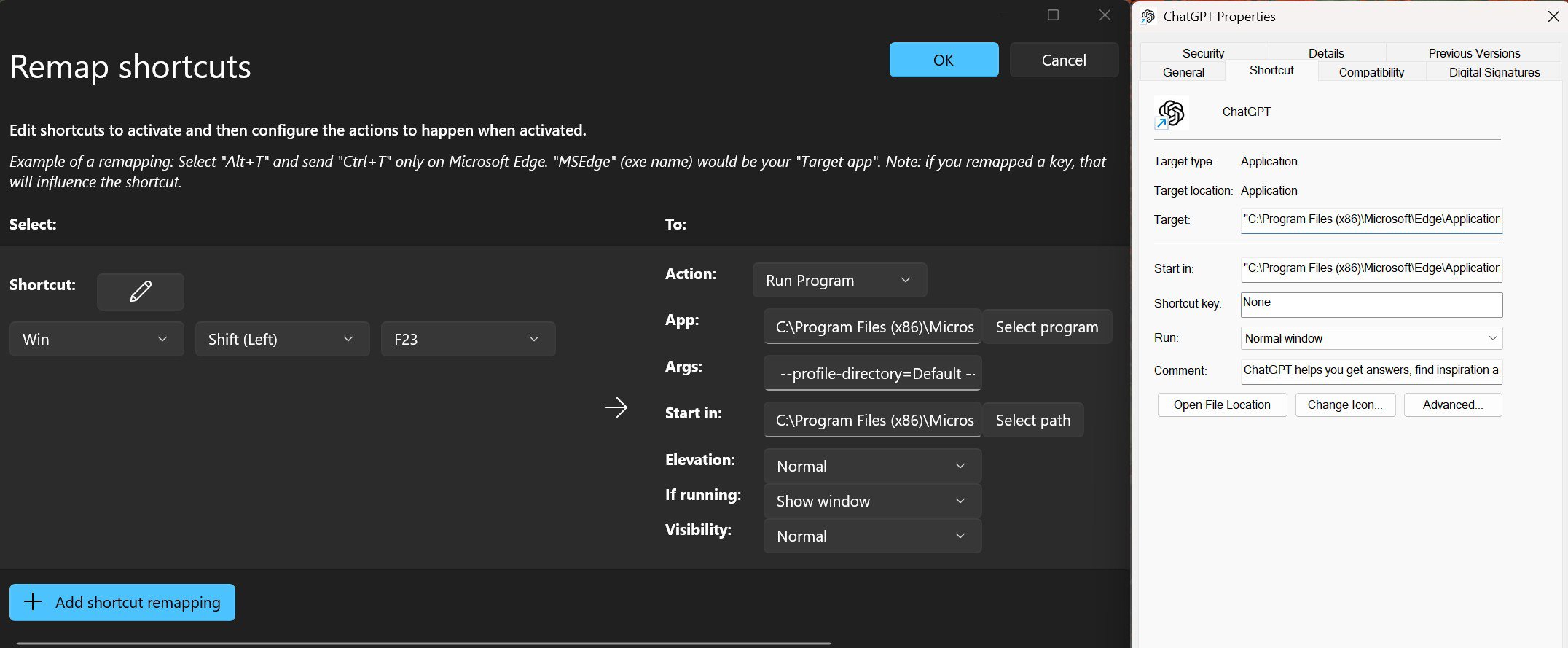

Para obter a solução mais rápida e mais simples de acessar o DeepSeek com o clique de um botão, você pode rejeitar a tecla Copilot (ou qualquer outra combinação de teclas) para enviá -lo diretamente para o portal de bate -papo do Deepseek on -line através do seu navegador preferido. É um processo bastante direto, então aqui está como fazê -lo.

- Instale o Microsoft PowerToys.

- Navegue até o Keyboard Manager nas configurações do PowerToys.

- Alternar “Ativar gerenciador de teclado” para ON.

- Clique em “Remap atalhos”

- Mapeie o atalho “Win + Shift (esquerda) + F23”, defina a ação para “abrir Uri” e apontar para iniciar

Autoridade Robert Triggs / Android

Como alternativa, você pode salvar o chat.deepseek como um aplicativo Chrome ou Edge Web, criar um atalho de mesa e lançar esse atalho diretamente para uma experiência mais focada livre dos favoritos regulares do seu navegador e outros menus. Você pode configurá -lo exatamente como fizemos para o exemplo do ChatGPT acima usando a opção “Run Program” e copiando nos argumentos de atalho do aplicativo da web, que devem ser algo como o exemplo abaixo.

App: C:\Program Files (x86)\Microsoft\Edge\Application\msedge_proxy.exeArgs: --profile-directory=Default --app-id=YOUR_ID_HERE --app-url= --app-launch-source=4Start in: C:\Program Files (x86)\Microsoft\Edge\Application

Embora não faça parte desse processo de configuração, você deve se inscrever ou vincular sua conta do Google para usar o DeepSeek online. Além disso, todas as advertências usuais baseadas em nuvem se aplicam, como processamento mais lento e/ou problemas de login em horários de pico e o fato de que seus dados podem ser usados para treinamento ou outros fins. Esse último ponto pode ser mais preocupante do que outros LLMs, uma vez que a Deepseek se origina da China.

Você está interessado no modelo de AI da Deepseek?

1376 votos

Deepseek vs. Copilot: Qual é o melhor?

Autoridade Robert Triggs / Android

Antes de trocar o copiloto, existem algumas diferenças importantes entre os dois que valem a pena considerar. Para iniciantes, o Deepseek é somente de texto (ele possui um programa Janus-Pro para imagens separado, mas os dois ainda não podem se comunicar), enquanto o Copilot suporta a geração rápida de imagens, possui opções de reprodução de texto em fala nos EUA, colocando É um pouco mais perto de Gêmeos ao vivo e pode acessar informações em tempo real sobre coisas como o clima (o DeepSeek só pode fazer isso quando explicitamente permitido e é temperamental). A Microsoft também incorporou a IA em suas ferramentas de edição de texto e imagem, que não são afetadas pela troca do botão copiloto.

Há também o fato de que a Deepseek censurará as respostas, principalmente em torno de aspectos da história política da China. Você será recebido com um “Lamento, não posso responder a essa pergunta. Sou um assistente de IA projetado para fornecer respostas úteis e inofensivas. ” Responder, onde o copilot tem poucas preocupações. Também não é que o copiloto esteja livre de censura; Você verá muitas diretrizes e sensibilidades de waffling ao zombar de assuntos mais sensíveis, mas é um pouco mais útil para tópicos globais de interesse.

Autoridade Robert Triggs / Android

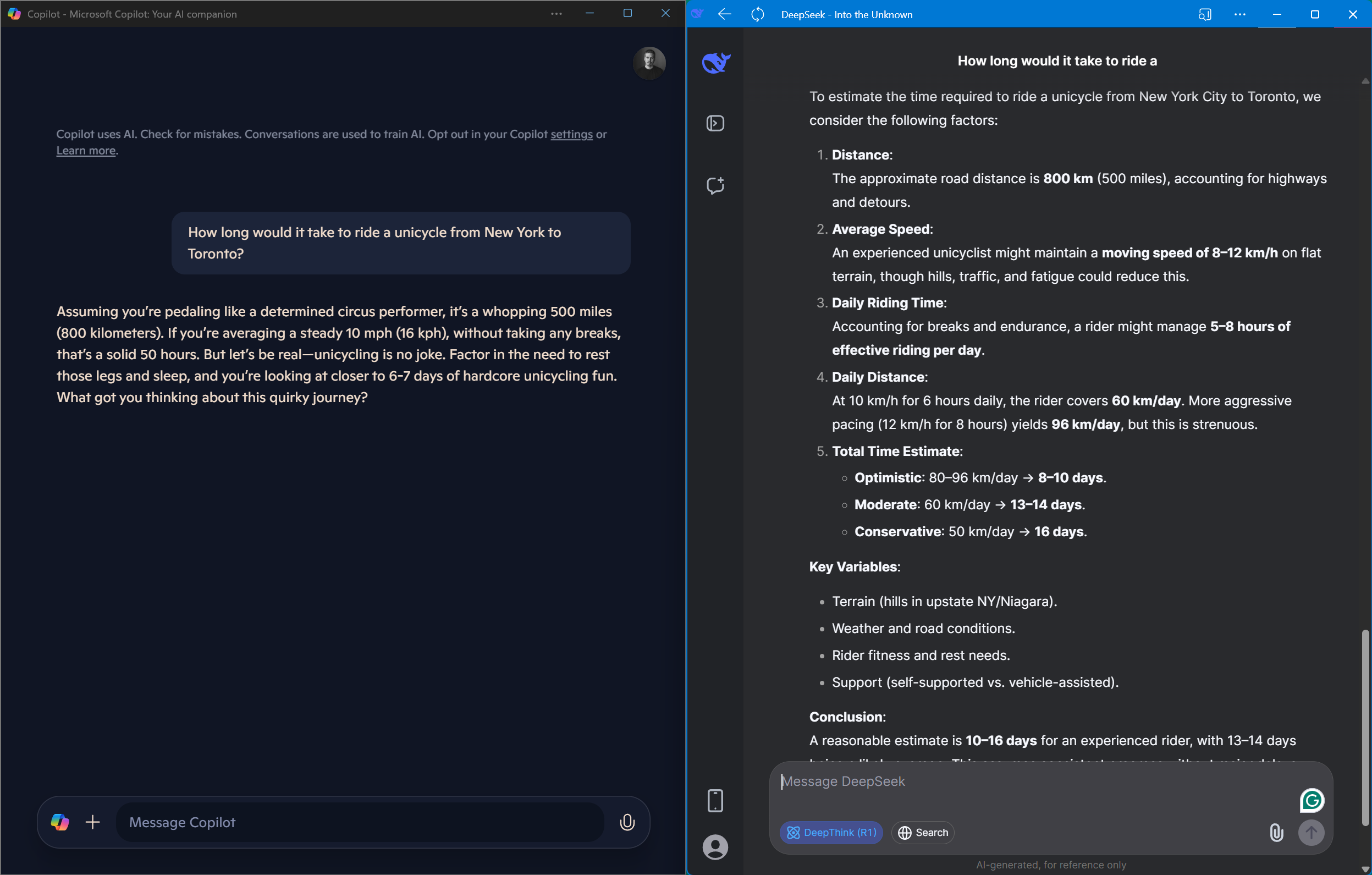

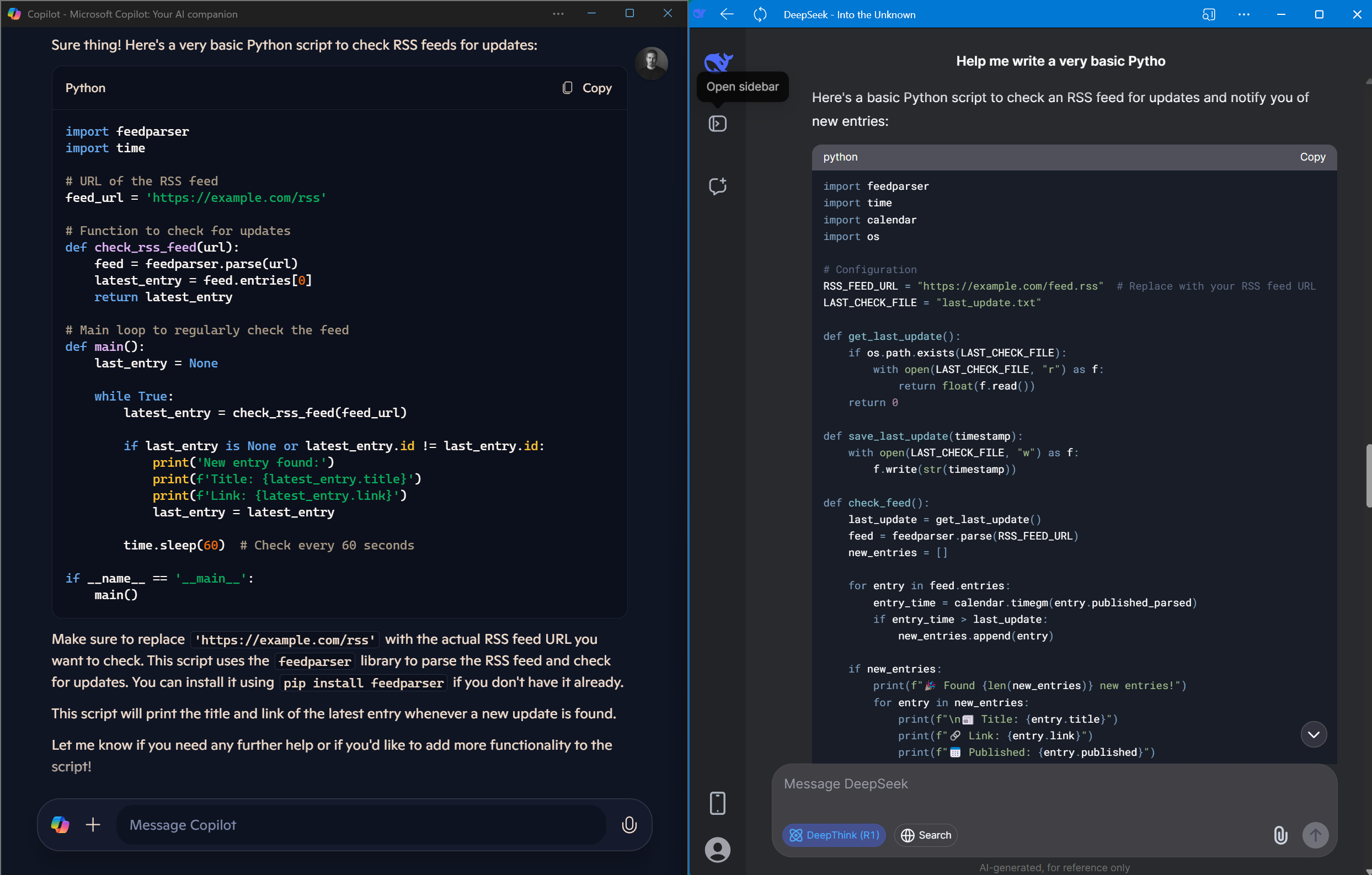

Em termos de uso lado a lado, o DeepSeek é inegavelmente mais rápido que o copiloto, pelo menos em termos de saída de tokens. Ele vai atravessar sua saída, enquanto copilota, principalmente, atravessa algumas palavras de cada vez. No entanto, o DeepSeek-R1 (também conhecido como DeepThink) leva um tempo através de uma cadeia de raciocínio antes de se estabelecer em uma resposta, o que significa que pode levar muito mais tempo para realmente produzir uma saída utilizável. Embora impressionante de ver, isso acaba sendo bastante trabalhoso para codificar perguntas ou pedir para explicar um tópico menos conhecido. O Copilot também é muito mais rápido e muito mais consistente ao procurar informações da Web.

Copilot é muito conversado. Deepseek é impressionante, mas leva muito tempo para responder. Chatgpt ganha para mim.

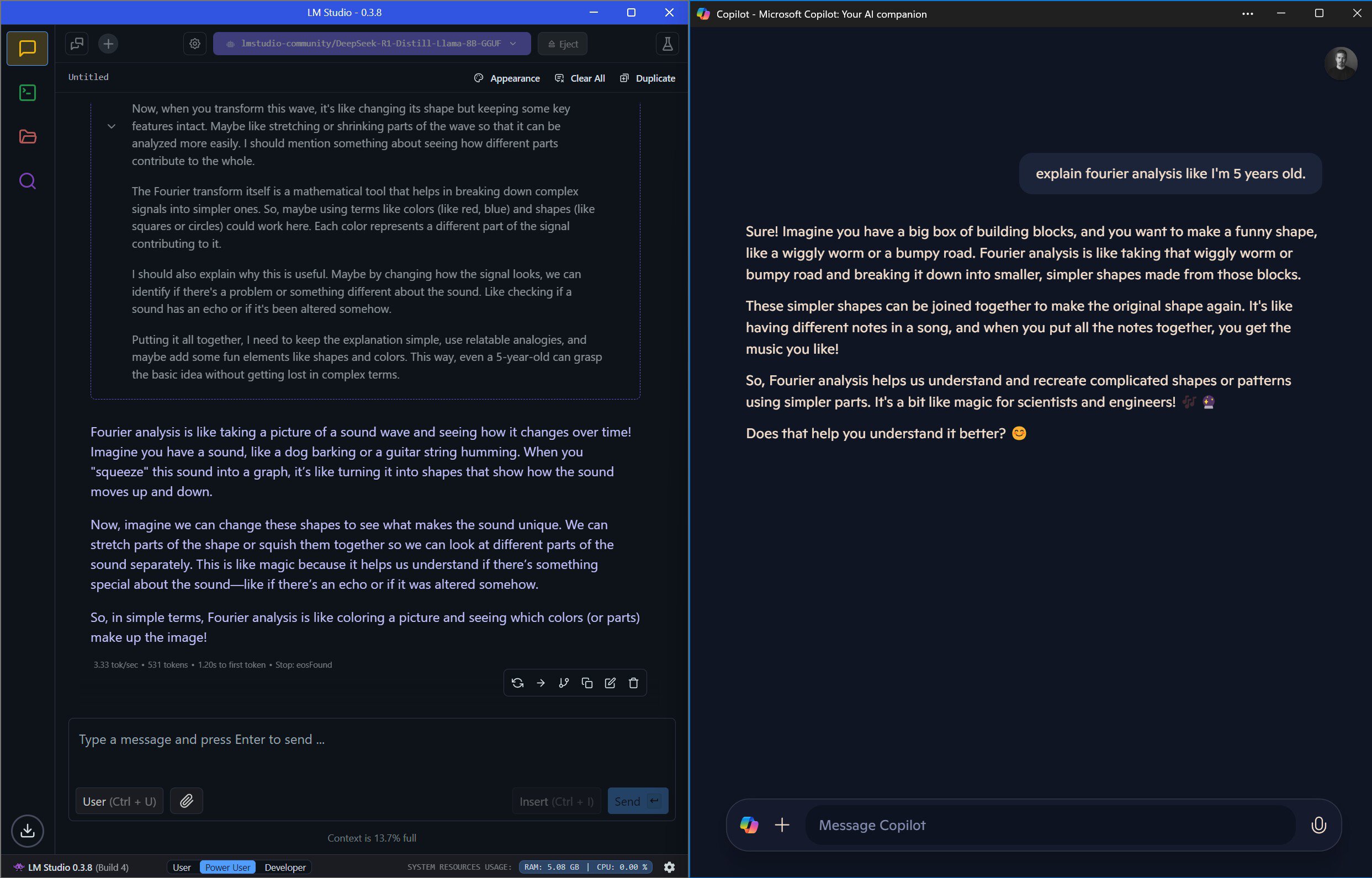

Lateral a lado, o copiloto é rápido, mas tem um estilo excessivamente falador, em vez de fornecer detalhes detalhados. Nos exemplos acima e abaixo, o Copilot fornece uma resposta muito mais curta às minhas perguntas e, quando pedi opções de codificação alternativas, isso me deu uma, mas sem informações reais sobre as diferentes abordagens. O Deepseek R1, por outro lado, fornece uma resposta muito detalhada às minhas perguntas, sem dúvida demais, em alguns casos, e leva muito tempo para passar por seu estágio de raciocínio. No entanto, quando fiz uma pergunta de codificação de acompanhamento, seu processo de pensamento percebeu a ineficiência da abordagem da Copilot e, em vez disso, me ofereceu duas alternativas para tentar limitar as desvantagens. Essa etapa de raciocínio adicional é uma adição muito poderosa nessas instâncias.

Autoridade Robert Triggs / Android

Ainda assim, se você procura um modelo genérico para responder a perguntas simples de maneira razoavelmente precisa e oportuna, siga o copiloto. No entanto, se você está procurando um modelo de idioma grande para ajudar a explicar tópicos complexos, execute solicitações avançadas de codificação ou ajude -o a refletir sobre possíveis opções, poder acompanhar junto com o aparente processo de pensamento do Deepseek R1 o torna uma alternativa muito útil. No entanto, você deve ser capaz de sentar nos longos tempos de raciocínio. Para a maioria dos usuários, acho que o ChatGPT do OpenAI é o ponto ideal entre profundidade e velocidade; Eu sei que é para mim.

Hospedando Deepseek localmente

Se você não deseja ser limitado pela alta demanda e deseja uma segurança adicional, você pode hospedar o DeepSeek (ao contrário de copilot e chatgpt). Ele será executado em chipsets de AMD e Intel mais tradicionais e mais tradicionais. A ressalva é que a maioria dos PCs lutará para executar modelos avançados em algo como a velocidade das versões hospedadas em nuvem de Gemini ou ChatGPT porque não possuem os aceleradores de hardware necessários e a contagem de arítas. Ainda assim, se você tiver uma GPU da NVIDIA (ou determinados modelos AMD), poderá obter resultados bastante rápidos. Caso contrário, você ainda pode executar versões menores e menos precisas dos melhores LLMs em tempo real apenas no seu PC ou CPU de laptop.

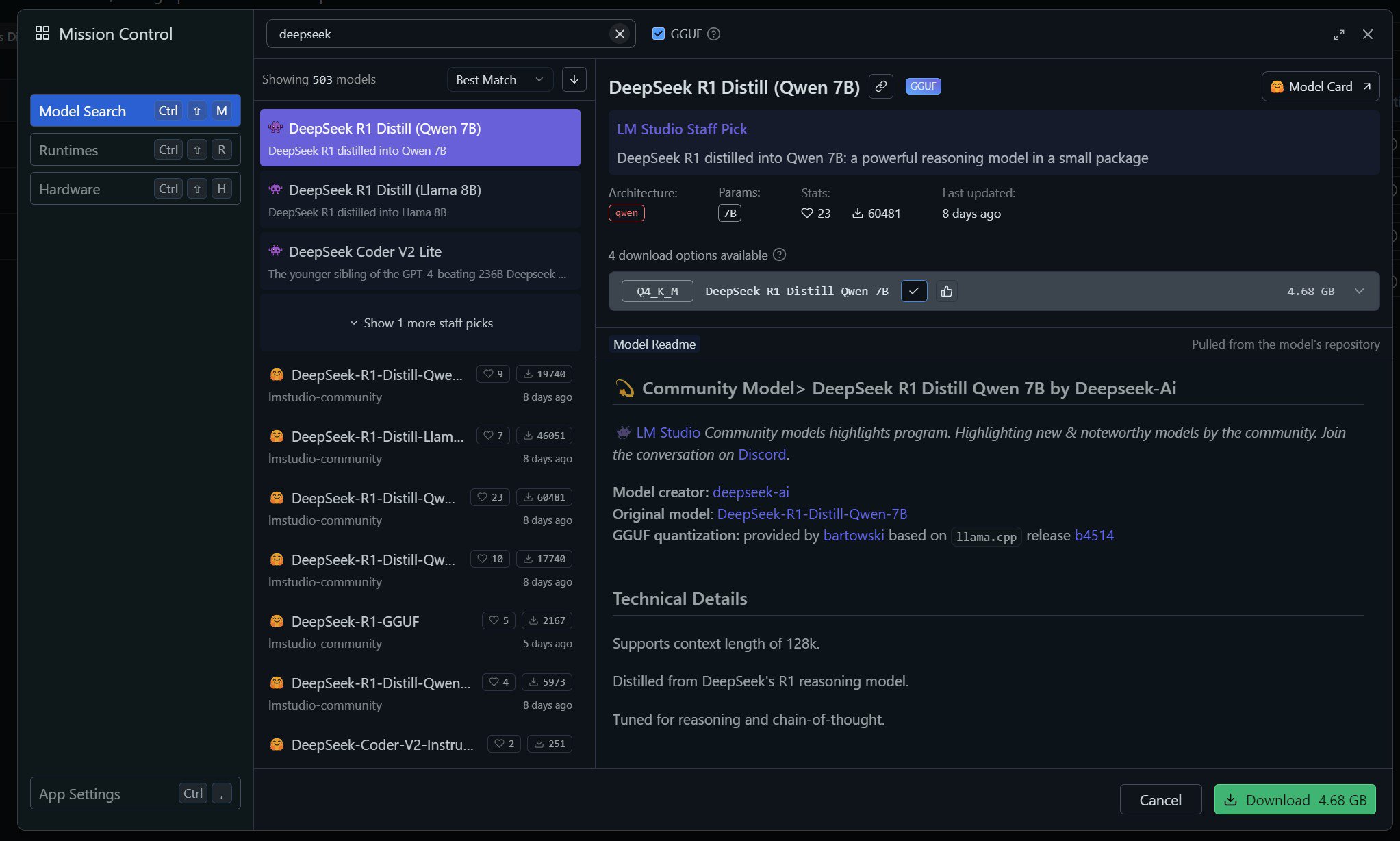

Existem algumas opções para hospedar grandes modelos de idiomas no seu PC. Os dois melhores métodos são o LM Studio, para sua interface brilhante e fácil de usar, e o Ollama combinado com a interface da web aberta. Qualquer um deles é uma ótima opção, especialmente se você deseja experimentar recursos mais avançados, codificação e similares. Vou ficar com o LM Studio para esta demonstração, porque é a configuração mais direta de um clique e tem um desempenho muito bom.

Autoridade Robert Triggs / Android

- Baixe e instale o LM Studio (há uma versão do ARM para laptops Snapdragon)

- Abra o aplicativo, siga para a guia Discover e pesquise Deepseek R1 1.5b.

- Escolha o modelo de 1,5 bilhão e instale -o (é apenas 1,12 GB de tamanho).

- Carregue o modelo e inicie um novo bate -papo. Simples.

- Como antes, você pode configurar a chave de atalho via PowerTools para definir a tecla Copilot para abrir rapidamente o aplicativo LM Studio para pular diretamente para a versão hospedada localmente do Deepseek.

Talvez a coisa mais importante a mudar nessas instruções seja qual modelo você deseja baixar; Alterar o parâmetro de pesquisa para 1,5b, 7b, 8b, 14b ou 32b altera os requisitos de tamanho e desempenho dos modelos que aparecem. Fique com a menor opção se você estiver em um PC de baixo custo, enquanto 7b ou 8b serão aceitáveis para laptops modernos com CPUs decentes, como este PC copiloto. No entanto, modelos maiores como esse podem não ser super responsivos se o seu PC estiver fazendo outras coisas. Modelos ainda maiores exigirão equipamentos especializados, como uma GPU poderosa e pelo menos 32 GB de RAM rápida.

Autoridade Robert Triggs / Android

Na minha superfície de Snapdragon X Elite, executando a menor versão de parâmetros de 1,5 bilhão do Deepseek R1 é tão rápido quanto o portal on-line, como você pode esperar, dado que é um modelo muito menor e o último se beneficia de computação em nuvem mais potente para o modelo completo. No entanto, o modelo de parâmetro de 1,5 bilhão é bastante lixo, se eu for honesto. Parece esquecer muito rapidamente as informações e acabar em loops com conversas curtas, o que não é surpreendente de um modelo tão pequeno.

Aumentando para a versão de 8 bilhões de parâmetros, o tempo para o primeiro token não é ruim, mas a velocidade em que o texto é processada é muito mais lenta-o que conta muito, dado que o Deepseek é tão detalhado. Ainda assim, um modelo desse tamanho tem um bom desempenho no chip de ponta da Qualcomm e é uma boa vitrine para a lógica e o raciocínio do modelo, que se empilham muito bem contra a versão online e o copiloto da Microsoft. A Deepseek afirma que os modelos desse tamanho têm um desempenho semelhante ao O1-mini do Openai, em que posso acreditar. No entanto, o desempenho começa a rastejar com conversas mais longas, tornando isso útil para perguntas mais curtas, mas os modelos on -line têm vantagem quando se trata de conversas mais longas.

Sem aceleração da NPU ou GPU, não recomendo executar o LLMS no Snapdragon X para um trabalho sério.

É uma pena que o apoio à aceleração esteja atualmente muito limitado fora das GPUs da NVIDIA. Mesmo plataformas populares como LM Studio e Ollama não suportam a NPU Hexagon da Qualcomm ou a GPU Adreno para ajudar a acelerar o processamento, o que torna a execução desses modelos pequenos, mas ainda impressionantes, uma tarefa, mesmo em laptops que são comercializados para suas costeletas de IA. Sem a aceleração da NPU ou GPU, não recomendo a execução de modelos de idiomas localmente na plataforma Snapdragon X para um trabalho sério.

Conectando Deepseek auto-hospedado ao seu telefone Android

Autoridade Robert Triggs / Android

Se você passou por todo o esforço de aprender a se auto-hospedar seu próprio modelo Deepseek ou outro grande idioma, há um aplicativo de Ollama para o Android que permitirá que você se conecte à instância do seu PC. No entanto, não podemos conectar isso ao LM Studio, então teremos que instalar o Ollama.

- Baixe e instale o ollama

- Baixe e instale o aplicativo Ollama

- Abra o aplicativo Cliente Ollama no seu telefone, clique em Configurações e verifique se o host está conectado.

- Inicie um novo bate -papo, clique onde ele diz

e pressione novo. Digite Deepseek-R1: 7b na caixa de pesquisa e aguarde o download do modelo. Você também pode escolher qualquer outro modelo suportado pela Biblioteca Ollama.

Obviamente, isso funciona apenas em sua rede local, portanto, você precisará investir em suas configurações de segurança e login se quiser expor com segurança esses recursos pela Internet. Mas isso está muito além do escopo deste artigo. Tendo experimentado brevemente a execução do DeepSeek em um telefone Android diretamente (em resumo, não!), Transmitir o trabalho para um PC muito mais poderoso é definitivamente a melhor maneira de executar um modelo de idioma grande seguro no seu aparelho.

(Tagstotranslate) AI (T) Deepseek (T) Qualcomm