Autoridade Robert Triggs / Android

A IA da Cloud pode ser impressionante, mas anseio pela segurança adicional que apenas offline, o processamento local fornece, especialmente à luz dos dados do Usuário Deepseek relatando de volta à China. Substituir o copilot pela Deepseek no meu laptop ontem me fez pensar se eu poderia executar grandes modelos de idiomas offline no meu smartphone também. Afinal, os principais telefones de hoje afirmam ser bastante poderosos, têm pool de RAM e ter aceleradores de IA dedicados que apenas os PCs mais modernos ou GPUs caros podem melhor. Certamente, isso pode ser feito.

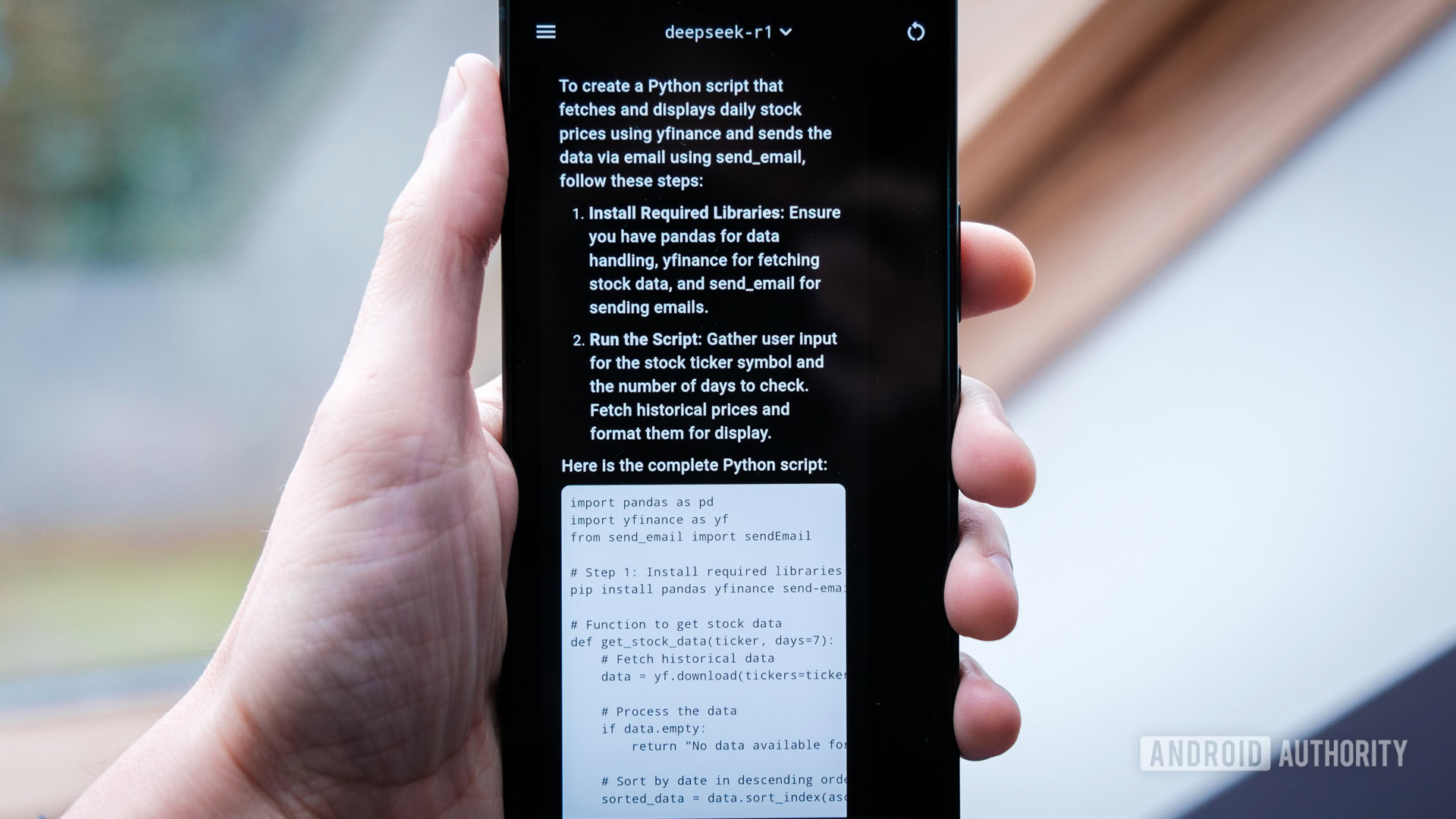

Bem, acontece que você pode executar uma versão condensada de Deepseek (e muitos outros grandes modelos de idiomas) localmente no seu telefone sem ser amarrado a uma conexão com a Internet. Embora as respostas não sejam tão rápidas ou precisas quanto as do modelo de nuvem de tamanho normal, os telefones que testei podem produzir respostas em um ritmo de leitura rápido, tornando-os muito utilizáveis. É importante ressaltar que os modelos menores ainda são bons em ajudar na solução de problemas, explicando tópicos complexos e até produzindo código de trabalho, assim como seu irmão maior.

Estou muito impressionado com os resultados, já que ele é executado em algo que se encaixa no meu bolso. Não posso recomendar que todos vocês saíssem para me copiar, mas aqueles que estão realmente interessados na paisagem de IA sempre em desenvolvimento provavelmente devem tentar executar modelos locais para si.

Autoridade Robert Triggs / Android

A instalação de um LLM offline no seu telefone pode ser uma dor, e a experiência não é tão perfeita quanto o uso de gêmeos do Google. Meu tempo gasto e mexendo também revelou que os smartphones não são os ambientes mais favoráveis para iniciantes para experimentar ou desenvolver novas ferramentas de IA. Isso precisará mudar para que tenhamos um mercado competitivo para aplicativos de IA atraentes, permitindo que os usuários se libertem dos grilhões de OEM de hoje.

Os modelos locais são surpreendentemente bem no Android, mas configurá -los não é para os fracos de coração.

Surpreendentemente, o desempenho não foi realmente o problema aqui; Os smartphones de elite Snapdragon 8, de ponta, testei que os modelos de parâmetros de sete e oito bilhões de tamanhos moderados e oito bilhões surpreendentemente bem na sua CPU, com uma velocidade de saída de 11 tokens por segundo-um pouco mais rápido do que a maioria das pessoas pode ler. Você pode até executar o parâmetro PHI-4 de 14 bilhões se tiver RAM suficiente, embora a saída caia para seis tokens ainda aceitáveis por segundo. No entanto, o Running LLMS é o mais difícil que eu empurrei as CPUs modernas de smartphones para fora do benchmarking e resulta em alguns aparelhos bastante quentes.

Impressionante, mesmo o envelhecimento do Pixel 7 Pro pode executar modelos menores de três bilhões de parâmetros, como o LLAMA3.2 da Meta, em um tokens aceitável por segundo, mas tentar o Deepseek maior está realmente pressionando o limite do que os telefones mais antigos podem fazer. Infelizmente, atualmente não há aceleração de NPU ou GPU disponível para qualquer smartphone usando os métodos que experimentei, o que daria aos telefones mais antigos um tiro real no braço. Como tal, modelos maiores são um não-go absoluto, mesmo nos chips mais poderosos do Android.

Sem acesso à Internet ou funções de assistente, poucos acharão o LLM local muito útil por conta própria.

Mesmo com poderosos aparelhos modernos, acho que a grande maioria das pessoas encontrará os casos de uso para executar um LLM no telefone muito limitado. Modelos impressionantes como Deepseek, Llama e Phi são ótimos assistentes para trabalhar em projetos de PC de tela grande, mas você lutará para usar suas habilidades em um pequeno smartphone. Atualmente, em forma de telefone, eles não podem acessar a Internet ou interagir com funções externas, como o Google Assistant Rotines, e é um pesadelo passar por documentos para resumir através da linha de comando. Há uma razão pela qual as marcas telefônicas estão incorporando ferramentas de IA em aplicativos como a galeria: direcionar casos de uso mais específicos é a melhor maneira de a maioria das pessoas interagir com modelos de vários tipos.

Portanto, embora seja muito promissor que os smartphones possam executar alguns dos melhores LLMs compactos por aí, há um longo caminho a percorrer antes que o ecossistema esteja próximo de apoiar a escolha do consumidor em assistentes. Como você verá abaixo, os smartphones não estão em foco para aqueles que treinam ou executa os modelos mais recentes, muito menos otimizar para a ampla gama de recursos de aceleração de hardware que a plataforma tem a oferecer. Dito isto, eu adoraria ver mais investimentos em desenvolvedores aqui, pois há claramente promessa.

Se você ainda deseja tentar executar o Deepseek ou muitos dos outros modelos populares de grandes idiomas sobre a segurança do seu próprio smartphone, detalhei duas opções para você começar.

Como instalar o DeepSeek no seu telefone (da maneira mais fácil)

Autoridade Robert Triggs / Android

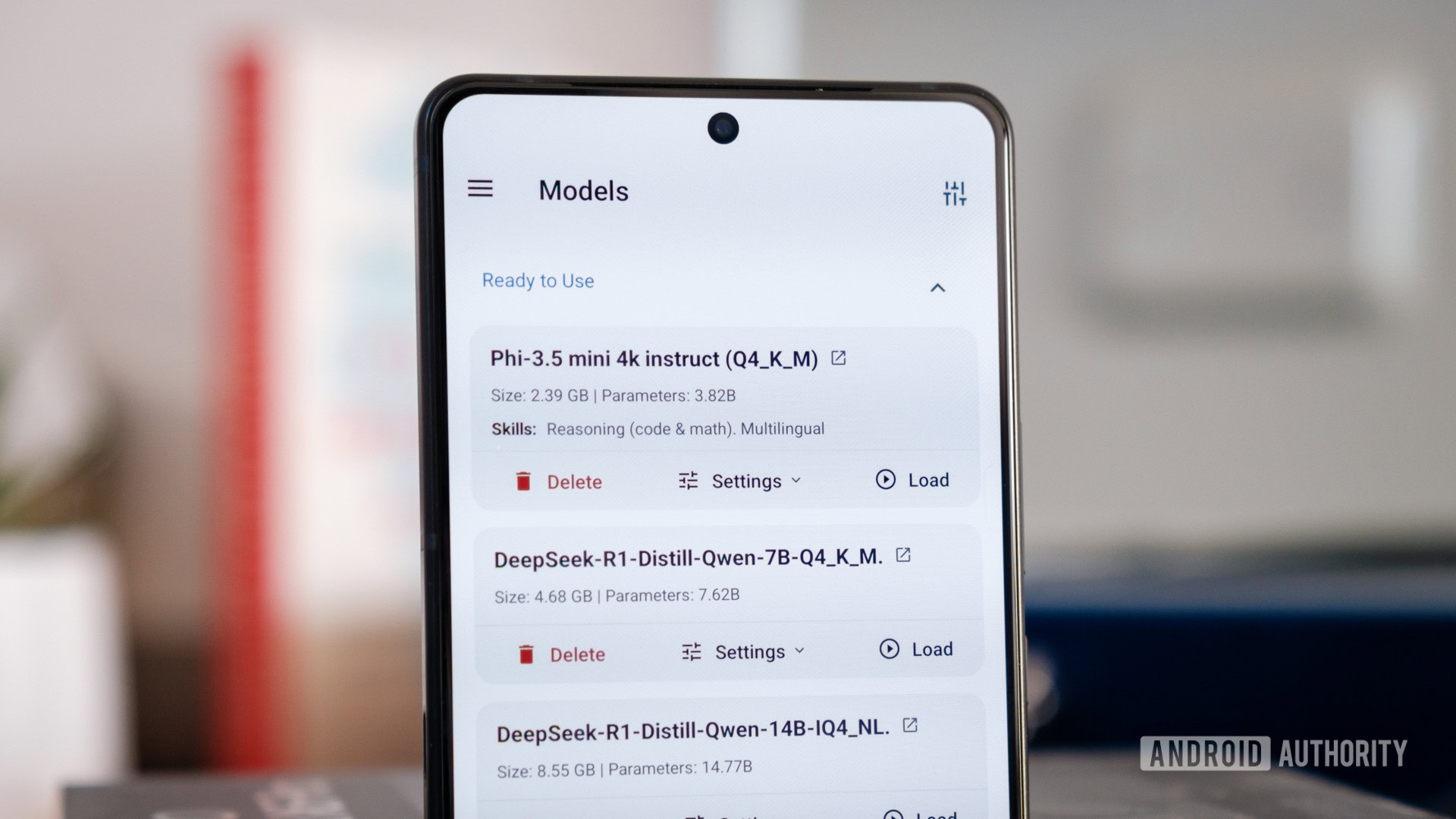

Se você deseja uma solução super fácil para conversar com a IA local no seu aparelho Android ou iOS, experimente o aplicativo PocketPal AI. Os proprietários de iPhone também podem experimentar o Privatellm. Você ainda precisará de um telefone com um processador decente e um pool de RAM rápida; 12 GB é aceitável em meus testes para executar modelos menores, condensados 7b/8b, mas 16 GB é melhor e essencial se você quiser tentar enfrentar o 14B.

Através do aplicativo, você pode acessar uma ampla gama de modelos através do popular portal Huggingface, que contém Deepseek, Llama, Phi e muitos, muitos outros. Na verdade, o enorme portfólio do Huggingface é um obstáculo para os não iniciados, e a funcionalidade de pesquisa no PocketPal AI é limitada. Os modelos não são particularmente bem rotulados na interface do usuário pequena; portanto, escolher o oficial ou o ideal para o seu dispositivo é difícil, fora de evitar os que exibem um aviso de memória. Felizmente, você pode importar manualmente modelos que você baixou, o que facilita o processo.

Quer executar a IA local no seu telefone? O PocketPal AI é uma maneira super fácil de fazer exatamente isso.

Infelizmente, experimentei alguns bugs com a IA do PocketPal, variando de downloads fracassados a bate-papos que não respondem e travamentos completos de aplicativos. Basicamente, nunca navegue para longe do aplicativo. Várias respostas também cortam prematuramente devido ao pequeno tamanho da janela padrão (um grande problema para o Deepseek detalhado); portanto, embora seja fácil de começar, você provavelmente terá que se aprofundar em configurações mais complexas. Também não consegui encontrar uma maneira de excluir bate -papos.

Felizmente, o desempenho é realmente sólido e descarregará automaticamente o modelo para reduzir a RAM quando não estiver em uso. Esta é de longe a maneira mais fácil de correr Deepseek e outros modelos populares offline, mas também há outra maneira.

… e o caminho mais difícil

Autoridade Robert Triggs / Android

Esse segundo método envolve a disputa de linha de comando via Termux para instalar o Ollama, uma ferramenta popular para executar os modelos LLM localmente (e a base do PocketPal AI) que eu achei um pouco mais confiável que o aplicativo anterior. Existem algumas maneiras de instalar o Ollama no seu telefone Android. Vou usar esse método bastante inteligente de Davide Fornelli, que usa o Proot para fornecer um ambiente Debian (e facilmente removível) para trabalhar. É o mais fácil de montar e gerenciar, especialmente porque você provavelmente acaba removendo Ollama depois de brincar um pouco. O desempenho com o Proot não é nativo, mas é bom o suficiente. Sugiro ler o guia completo para entender o processo, mas listei as etapas essenciais abaixo.

Siga estas etapas no seu telefone Android para instalar o Ollama.

- Instale e abra o aplicativo Termux

pkgupdate && pkg upgrade– Atualizar para os pacotes mais recentespkg install proot-distro– Instale o prot-Distropd install debian– Instale o Debianpd login debian– Faça login em nosso ambiente Debiancurl-fsSL|sh– Faça o download e instale o ollamaollama serve– Comece a executar o servidor Ollama

Você pode sair do ambiente do Debian via CTRL+D a qualquer hora. Para remover o Ollama, todos os seus modelos baixados e o ambiente Debian, siga as etapas abaixo. Isso levará seu telefone de volta ao seu estado original.

CTRL+Ce/ouCTRL+D– Saia de Ollama e certifique -se de sair do ambiente Debian no Termux.pd remove debian– Isso excluirá tudo o que você fez no ambiente (não tocará em nada).pkg remove proot-distro– Isso é opcional, mas também vou remover a prot (é apenas alguns MB de tamanho, para que você possa mantê -lo facilmente).

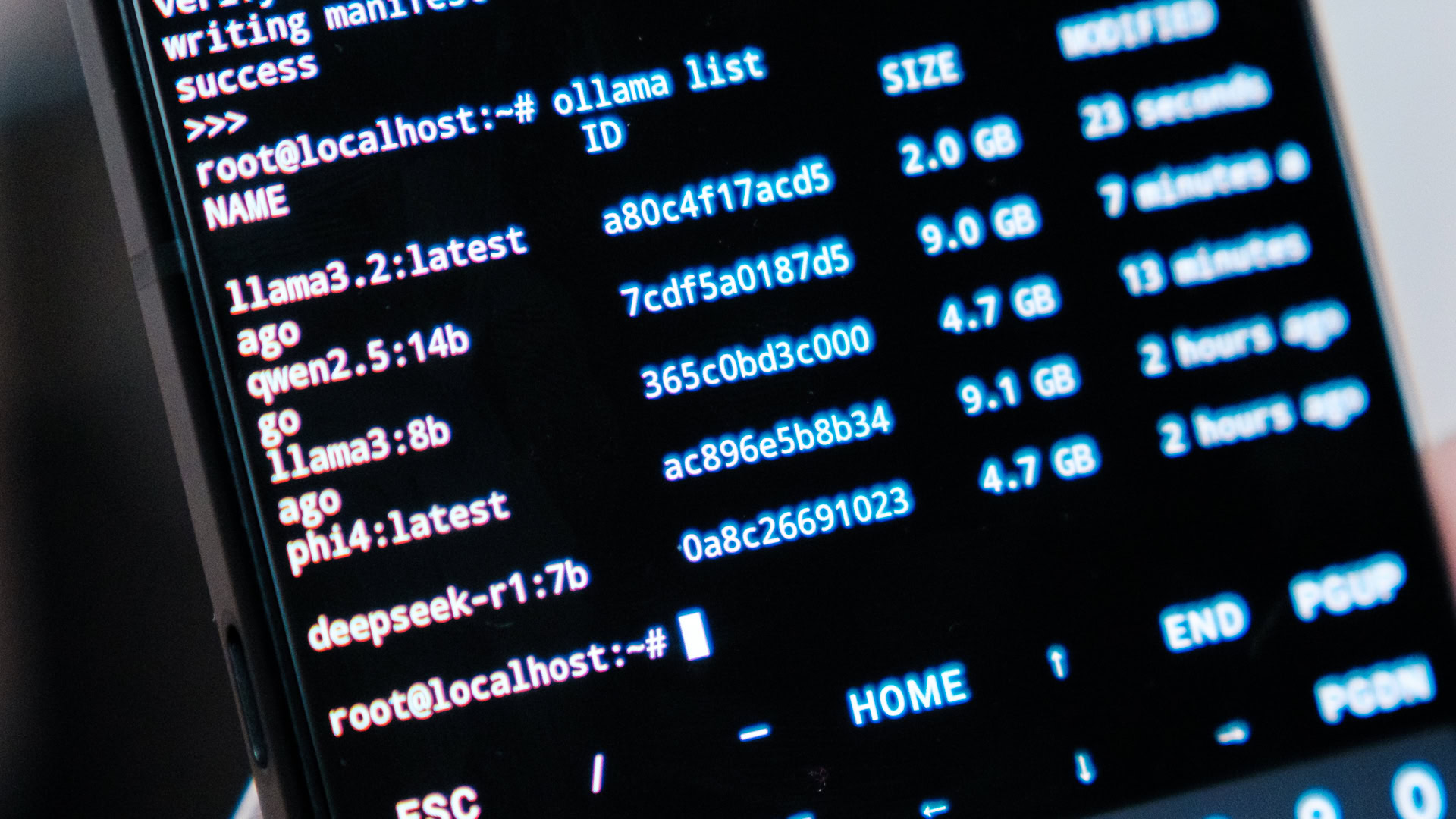

Com o Ollama instalado, faça login em nosso ambiente Debian via Termux e Run Ollama serve Para iniciar o servidor. Você pode pressionar CTRL+C Para encerrar a instância do servidor e liberar os recursos do seu telefone. Enquanto isso estiver em execução, temos algumas opções para interagir com Ollama e começar a executar alguns modelos de idiomas grandes.

Você pode abrir uma segunda janela no Termux, fazer login em nosso ambiente Debian e prosseguir com as interações da linha de comando ollama. Esta é a maneira mais rápida e estável de interagir com o Ollama, principalmente em smartphones de baixa ram, e é (atualmente) a única maneira de remover modelos para liberar armazenamento.

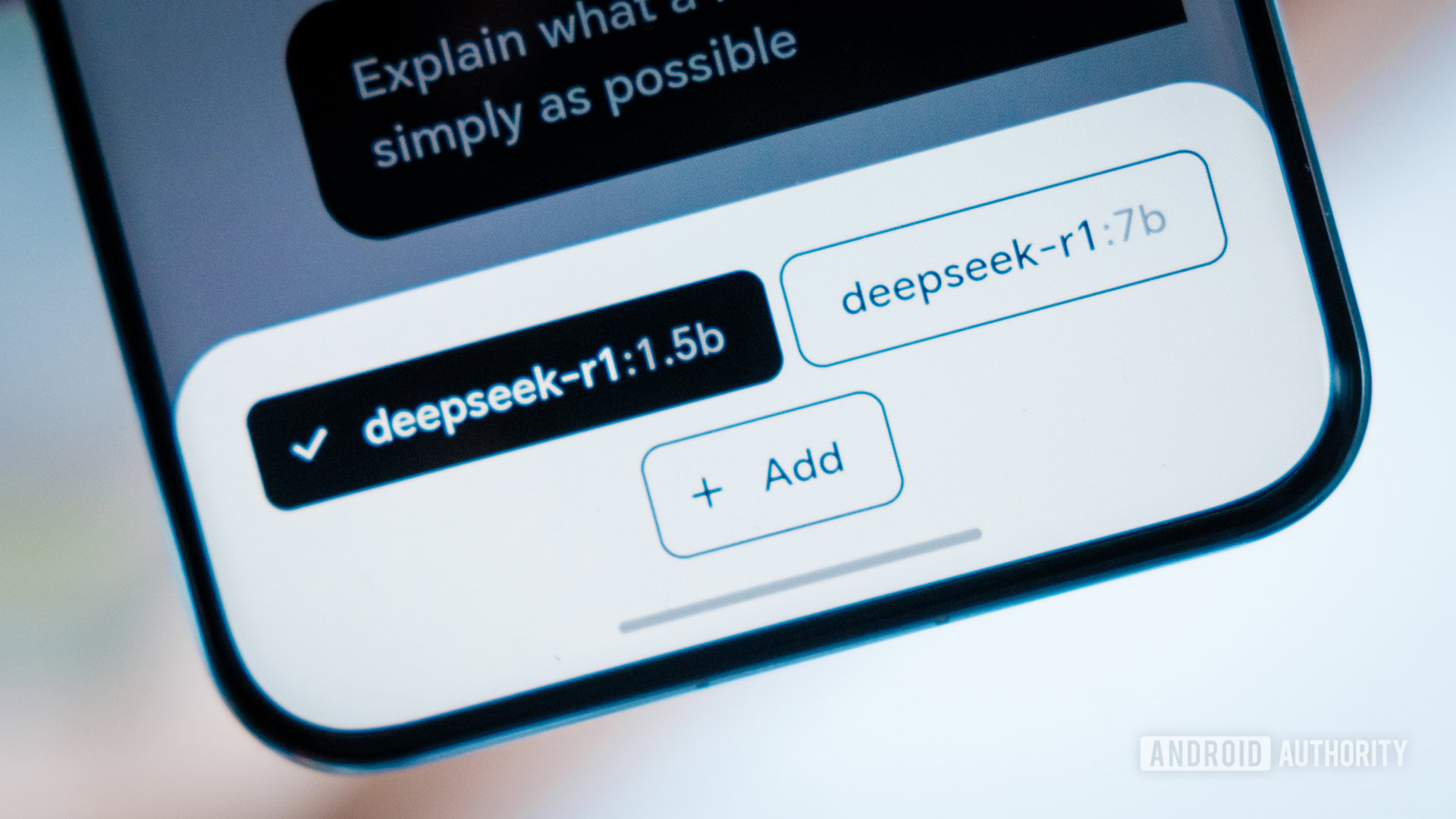

Para começar a conversar com o Deepseek-R1, digite ollama run deepseek-r1:7b. Depois de baixado, você pode digitar a linha de comando e o modelo retornará as respostas. Você também pode escolher qualquer outro modelo de tamanho adequado da biblioteca Ollama bem organizada.

ollama run MODEL_NAME– Faça o download e/ou execute um modeloollama stop MODEL_NAME– Pare um modelo (o ollama descarrega automaticamente os modelos após cinco minutos)ollama pull MODEL_NAME– Baixe um modeloollama rm MODEL_NAME– Exclua um modeloollama ps– Veja o modelo atualmente carregadoollama list– Liste todos os modelos instalados

A alternativa é instalar o aplicativo Ollama do JHUBI1 para Android. Ele se comunica com o Ollama e fornece uma interface de usuário melhor para conversar e instalar modelos de sua escolha. A desvantagem é que é outro aplicativo para executar, que consome preciosos ram e pode dar um pouco de um smartphone com menos desempenho. As respostas também parecem um pouco mais lentas do que correr na linha de comando, devido à sobrecarga de comunicação com Ollama. Ainda assim, é uma atualização sólida de qualidade de vida se você planeja executar perpetuamente um LLM local.

Qual LLMS posso executar em um smartphone?

Autoridade Robert Triggs / Android

Embora assistir ao processo de pensamento de Deepseek seja impressionante, não acho que seja necessariamente o modelo de idioma grande mais útil por aí, especialmente para correr em um telefone. Até o modelo de sete bilhões de parâmetros fará uma pausa com conversas mais longas em uma elite 8, o que a torna uma tarefa para usar quando combinada com sua longa cadeia de raciocínio. Felizmente, há cargas mais modelos para escolher que podem ser executados mais rapidamente e ainda fornecem excelentes resultados. A lhama da Meta, a PHI da Microsoft e o Mistral podem correr bem em uma variedade de telefones; Você só precisa escolher o modelo de tamanho mais apropriado, dependendo da RAM e dos recursos de processamento do seu smartphone.

Em termos gerais, os modelos de três bilhões de parâmetros precisarão de até 2,5 GB de RAM gratuita, enquanto sete e oito bilhões de modelos de parâmetros precisam de 5-7 GB para mantê-los. Os modelos 14b podem comer até 10 GB e assim por diante, dobrando aproximadamente a quantidade de RAM toda vez que você dobrar o tamanho do modelo. Dado que os smartphones também precisam compartilhar RAM com o sistema operacional, outros aplicativos e GPU, você precisa de pelo menos um buffer de 50% (ainda mais se quiser manter o modelo funcionando constante Para mover o modelo para o espaço de troca. Como um estádio, os telefones com 12 GB de RAM rápida executarão sete e oito bilhões de modelos de parâmetros, mas você precisará de 16 GB ou mais para tentar 14b. E lembre -se, o Pixel 9 Pro do Google participa de um pouco de RAM para seu próprio modelo Gemini.

Os telefones Android podem escolher de uma enorme variedade de modelos de IA menores.

Obviamente, mais parâmetros exigem muito mais poder de processamento para triturar o modelo também. Até a elite do Snapdragon 8 diminui um pouco com o PHI-4: 14B da Microsoft e o QWEN2.5: 14B do Alibaba, embora ambos sejam razoavelmente utilizáveis no colossal 24 GB Asus Rog Telefone 9 Pro com quem eu costumava testar. Se você deseja algo que sai na leitura do ritmo no hardware atual ou de última geração que ainda oferece um nível decente de precisão, fique com 8b no máximo. Para telefones mais antigos ou de médio alcance, cair com modelos 3B menores sacrifica muito mais precisão, mas deve permitir uma saída de token que não é o ritmo completo de um caracol.

Claro, isso é apenas se você quiser executar a IA localmente. Se você estiver satisfeito com as trocas de computação em nuvem, pode acessar modelos muito mais poderosos como ChatGPT, Gemini e o Deepseek em tamanho real através do seu navegador da Web ou de seus respectivos aplicativos dedicados. Ainda assim, executar a IA no meu telefone certamente foi um experimento interessante, e melhores desenvolvedores do que eu poderia explorar muito mais potencial com os ganchos da API de Ollama.

(Tagstotranslate) Ai